Bạn đã bao giờ tự hỏi chính mình khái niệm nỗ lực là gì chưa? Đó là một cách để…

Bạn đã từng biết những mẹo gỡ miếng plastic tại nhà chưa? Đừng lo, có một số mẹo nhỏ giúp…

Bạn đã bao giờ tự hỏi Draft là gì chưa? Đây được xem như là một thuật ngữ được sử…

Khi học môn hóa học, bạn đã bao giờ tự hỏi Electron hóa trị là gì chưa? Nó là số…

Bạn đã bao giờ tò mò về sự khác biệt giữa kiểu hình là gì và kiểu gen là gì…

Bạn đã bao giờ tự hỏi Cây hấp thụ nitơ ở hình thức nào chưa? Tác dụng của nitơ trong…

Bạn có bao giờ tự hỏi về Bảng đơn vị đo thời gian và mẹo quy đổi đơn vị thời…

Bạn đã bao giờ tự hỏi thuật ngữ là gì chưa? Khái niệm thuật ngữ đề cập đến các từ…

Bạn đã bao giờ tự hỏi chế độ khái niệm Rinse trong máy giặt là gì chưa? Đó quá trình…

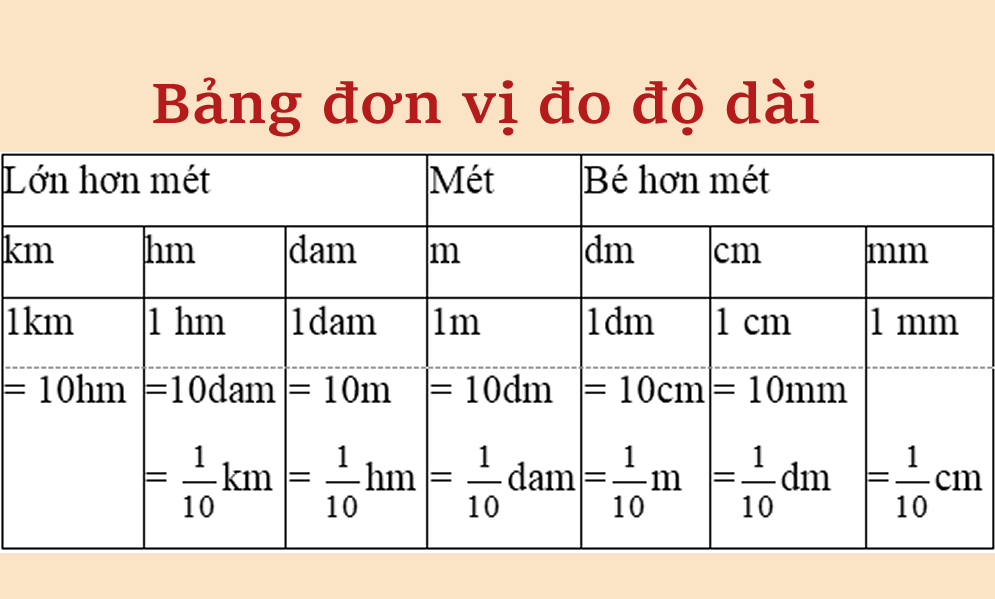

Khi tìm hiểu và khám phá Chuyển đổi 1km thành bao nhiêu m, dm, cm? (1km=m), chúng ta cần sử…

Khái niệm của Cẩu lương và cẩu huyết là hai thuật ngữ phổ biến trong cuộc sống hàng ngày của…

Nhiều người luôn thắc mắc sự thông cảm là gì? Với mình, đó là khả năng hiểu và chia sẻ…

Bạn đã bao giờ tìm hiểu về khái niệm Ara Ara có nghĩa là gì trong tiếng Nhật chưa? Ara…

Quy tắc bàn tay trái lớp 11 là gì? Đây là một khái niệm trong môn Vật lý được giảng…

Nhiều bạn thường thắc mắc khái niệm Lai phân tích là gì và vì sao nó quan trọng? Việc tìm…

KDA là gì? Trong trò chơi, KDA là thuật ngữ được sử dụng phổ biến. Đối với những game thủ…

Đã bao giờ bạn tự hỏi ý nghĩa của lãng mạn trong cuộc sống mỗi người là gì? Lãng mạn…

Đa thức là gì? Những đa thức thường được sử dụng để mô hình hóa các quan hệ toán học…

Bạn đã từng nghe đến khái niệm tự đa đoan nhưng không hiểu rõ ý nghĩa của tự đa đoan…

Bạn đã biết ngày 14/5 có ý nghĩa gì chưa? Ngoài những ngày kỷ niệm quan trọng như Lễ Tình…

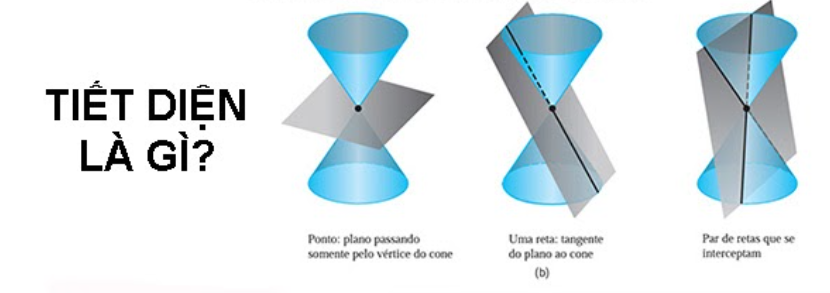

Tiết diện là gì? Trong ngành xây dựng và điện, tiết diện là một thuật ngữ quan trọng mà các…

Put off là gì? Đây là cụm từ được sử dụng phổ biến trong tiếng Anh và có nhiều cách…

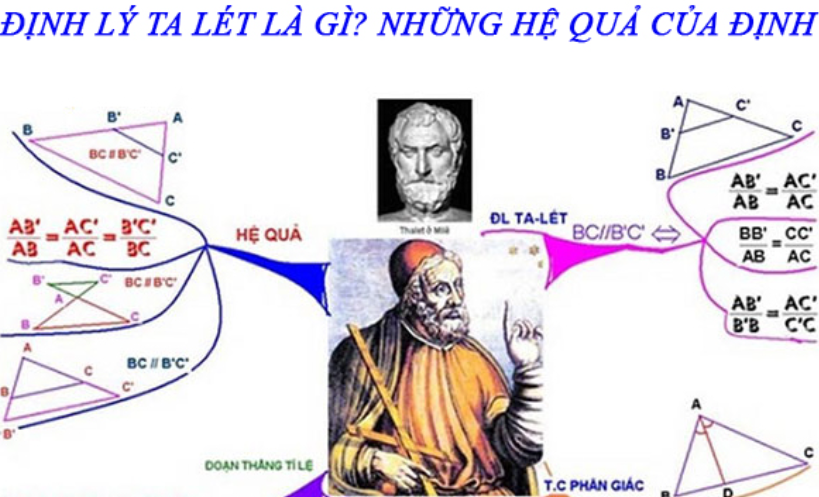

Bạn đã từng nghe qua Định lý Thales chưa? Đây là một định lý rất quan trọng trong lĩnh vực…

Cây đắng cảy không chỉ là một loại rau rừng, mà còn là một thảo dược quen thuộc đối với…

Bạn đã bao giờ thắc mắc điểm khác nhau giữa Trọng lượng và Khối lượng là gì chưa? Trọng lượng…

Bạn đã từng cảm nhận trạng thái An nhiên là gì trong cuộc sống của mình? Trạng thái này đòi…

Nếu bạn là fan truyện tranh Nhật Bản thì bạn chắc chắn không thể bỏ qua bộ truyện Metamorphosis hay…

Văn miêu tả là gì? Là một vấn đề được nhiều bạn học sinh quan tâm và tìm hiểu. Văn…

Khi bạn bắt đầu học ngữ văn, có bao giờ bạn thắc mắc Biện pháp tu từ trong văn bản…

Bạn có bao giờ tự hỏi ý nghĩa câu nói Hoa rơi cửa Phật, mọi sự tùy duyên là gì…

Bạn đã bao giờ tự hỏi lòng biết ơn là gì và tại sao nó quan trọng không? Lòng biết…

Trước khi đi du lịch, có bao giờ bạn tự hỏi Phú Yên thuộc tỉnh nào và nằm ở đâu…

Bạn đã bao giờ tự hỏi rằng niềm đam mê là gì và tại sao nó quan trọng trong cuộc…

Động vật ruột khoang là một nhóm động vật sống chủ yếu ở biển, đặc biệt đa dạng về số…

Có bao giờ bạn thắc mắc Xin lỗi là gì chưa? Đây hành động thể hiện sự biết ơn và…

Đặc trưng của thể loại phim tình cảm hài Hàn Quốc là gì? Đây là một thể loại phim được…

Thán từ và trợ từ trong Ngữ văn là hai khái niệm quen thuộc và phổ biến trong văn học…

Qua một số ứng dụng hẹn hò hiện nay, ta có thể dễ dàng gặp các từ viết tắt như…

Cát tuyến trong hình học và cách vẽ là một khái niệm hình học quan trọng. Nó liên quan đến…

Trên các nền tảng như Tiktok, Facebook thường xuất hiện cụm từ “Chu pa pi mô nha nhố là gì?”…

112, 113, 114, 115 là số điện thoại gì? Đây là cụm số điện thoại khẩn cấp phổ biến tại…

Để phát triển và thành công trong xã hội hiện đại, tính tự chủ là gì đóng vai trò vô…

Thể thơ tự do là gì? Dòng thơ này xuất hiện từ khi nào? Được biết đây là thể thơ…

Trong quá trình học về axit và bazơ, chúng ta đã tìm hiểu về chất lưỡng tính là gì thuộc…

Tinh thần đoàn kết là gì là một trong những giá trị quý báu của người dân Việt Nam, đóng…

Ở lớp 3, các em sẽ học về bảng đơn vị đo độ dài, đó là một kiến thức mới…

Trong chương trình toán THCS, người ta đã được làm quen với các khái niệm tập hợp số tự nhiên,…

Bạn đã bao giờ tự hỏi về ý nghĩa thực sự của cống hiến không? Trong một tổ chức hoặc một…

Thể thơ bát ngôn, còn được biết đến với tên gọi thể thơ 8 chữ, là một dạng thể thơ…

Spoi và Spoiler là gì? Thông thường, khi xem một bộ phim bom tấn hay một tác phẩm giải trí…

Tỉ khối hơi và cách tính tỉ khối hơi chất khí là những kiến thức quan trọng khi nghiên cứu…

Chắc hẳn mọi người đều đã từng nghe đến thuật ngữ kinh tuyến và vĩ tuyến, cũng như kinh độ…

Cây lá cẩm là gì? Lá cẩm đã trở thành một nguyên liệu không thể thiếu trong việc nấu xôi…

Bạn đã bao giờ tự hỏi ý nghĩa của giờ trùng phút là gì? Khi chúng ta nhìn thấy đồng…

Gato là gì? Rất phổ biến trên mạng xã hội hiện nay, từ gato và các biểu thức liên quan…

Nhạc R&B là gì? Dòng nhạc R&B, viết tắt của Rhythm and Blues, ngày càng phổ biến trên toàn thế…

Đối với những fan Kpop đích thực, từ “bash” đã quá quen thuộc.Nhưng đối với những bạn mới xem KPOP,…

FeCl2 được sử dụng rộng rãi trong cuộc sống hiện nay. Tuy nhiên,FeCl2 có màu gì và là chất gì…

Bạn có biết về quy tắc bàn tay phải trong vận động học không? Quy tắc bàn tay phải hay…

Mặc dù đường trung trực là một khái niệm đã được nghiên cứu rất nhiều, tuy nhiên, nhiều người vẫn…